Alguma vez você já se perguntou sobre a lógica complexa por trás dos sistemas de conteúdo e recomendação patrocinados encontrados nas redes sociais e nas páginas dos varejistas online? Com os avanços significativos nas tecnologias de inteligência artificial (IA), agora interagimos com sistemas habilitados para IA diariamente, tanto em nível pessoal quanto profissional. Desde os sistemas de reconhecimento de imagem e voz em nossos telefones celulares até os complexos sistemas de tomada de decisão usados por pesquisadores, formuladores de políticas, profissionais médicos, banqueiros etc., a escala do uso da IA está aumentando sem fim.

Hoje as ferramentas de IA são capazes de produzir resultados altamente precisos, mas também são altamente complexos. Eles usam modelos de aprendizado de máquina (ML) que são opacos e não intuitivos, apropriadamente chamados de modelos de caixa preta. Os usuários têm pouco ou nenhum conhecimento sobre o processo por trás da tomada de decisão e das previsões fornecidas por essas ferramentas. Quando os dados são alimentados com a ferramenta IA, não há explicação para os resultados que produz; essa falta de explicabilidade obstrui a capacidade das pessoas de confiar na IA, levando a desconfiar das decisões fornecidas por essas ferramentas.

A IA de caixa branca, ou IA explicável (XAI), aborda esse problema, oferecendo um nível de transparência aos usuários e fornecendo explicações sobre o raciocínio por trás das decisões. Esse modelo ajuda os usuários a entender por que um sistema de IA funciona de certa maneira, avalia suas vulnerabilidades, verifica a saída e protege contra preconceitos não intencionais na saída. A XAI também faz da aderência aos padrões regulatórios ou requisitos de política um pedaço de bolo; regulamentos de dados como o Regulamento Geral de Proteção de Dados (GDPR) e o California Consumer Privacy Act (CCPA) concedem aos consumidores o direito de solicitar uma explicação sobre uma disputa automatizada, e a XAI pode fornecer esses dados com facilidade.

“O Gartner prevê que ‘até 2023, 40% das equipes de infraestrutura e operações usarão automação aumentada por IA nas empresas, resultando em maior produtividade de TI. À medida que as empresas passam da IA estreita para a IA geral – e começam a automatizar não apenas processos, mas também decisões – é vital que as ferramentas de IA expliquem seu comportamento”, diz Ramprakash Ramamoorthy, gerente de produtos da Zoho Labs.

Agora que sabemos o que XAI significa e faz, aqui estão cinco leituras interessantes que discutem mais sobre XAI.

1. Compreendendo a IA explicável

Diferentes modelos de IA requerem diferentes níveis de explicabilidade e transparência. Esses níveis devem ser determinados pelas consequências que podem surgir do sistema de IA, e as empresas devem implementar a governança para supervisionar e regular as operações do sistema.

2. Como a IA explicável está ajudando os algoritmos a evitar vieses

Às vezes, preconceitos sutis e profundos podem penetrar nos dados alimentados em algoritmos complexos de IA. Tornar os modelos de IA cada vez mais explicáveis é essencial para corrigir os fatores que inadvertidamente levam ao viés.

3. IA explicável na área da saúde

A capacidade de explicação da IA é particularmente crítica no setor de saúde. Os tipos de decisões e previsões feitas pelos sistemas habilitados para IA aqui são fundamentais para a vida, a morte e o bem-estar pessoal. O XAI reduz incertezas nos resultados, tornando as coisas menos arriscadas.

4. Por que a IA explicável é uma estratégia de negócios crítica

Para as empresas, a XAI ajuda a melhorar a governança. Quando o processo de tomada de decisão se torna transparente, a conformidade com os regulamentos é mais fácil e menos problemática. Isso também abre caminho para o alinhamento das decisões baseadas em IA com os objetivos éticos e comerciais da empresa.

5. Por que pedir para uma IA se explicar pode piorar as coisas

Toda moeda tem dois lados. Como qualquer outra tecnologia, dizem os pesquisadores, a XAI também tem suas deficiências. Descobrir as melhores maneiras de a IA se explicar pode ajudar a impedir que os usuários confiem demais na IA.

Simplificando, antes de entrar em um carro autônomo, você quer saber como ele funciona para garantir a segurança. No caso de um carro autônomo entrar em um acidente, um funcionário da lei precisa saber o que aconteceu no sistema de IA para causar o acidente, e a XAI pode oferecer essa explicação. O conhecimento por trás do motivo pelo qual o carro não conseguiu evitar um acidente é uma lição valiosa a ser aprendida tanto para os seres humanos quanto para a IA.

Fonte: ManageEngine.

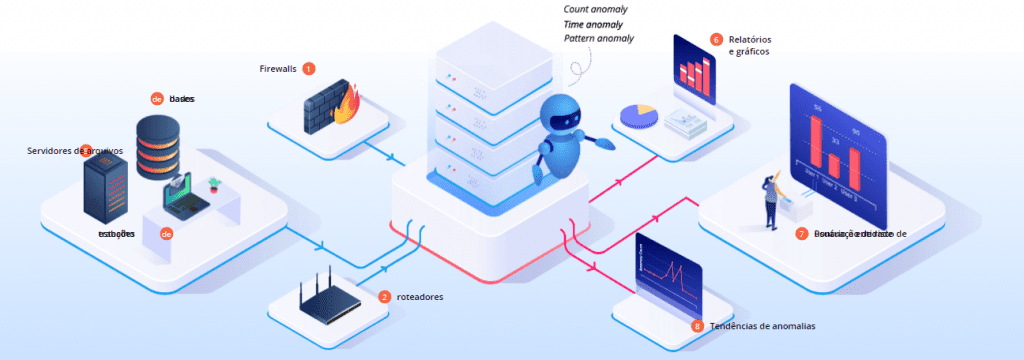

Log360 UEBA

O Log360 UEBA analisa logs de diferentes fontes, incluindo firewalls, roteadores, estações de trabalho, bancos de dados e servidores de arquivos. Qualquer desvio do comportamento normal é classificado como uma anomalia de tempo, contagem ou padrão. Em seguida, fornece informações acionáveis ao administrador de TI com o uso de pontuações de risco, tendências de anomalias e relatórios intuitivos para que você tome as ações necessárias.

Não perca mais tempo e garanta a segurança inteligente iniciando sua avaliação gratuita de 30 dias, contando sempre com o time da ACSoftware, seus especialistas ManageEngine no Brasil, tanto pra vendas, suporte, consultoria e treinamento.

ACSoftware revenda e distribuidora ManageEngine no Brasil. – Fone / WhatsApp (11) 4063 9639.